Wie autonomes Fahren sicherer wird

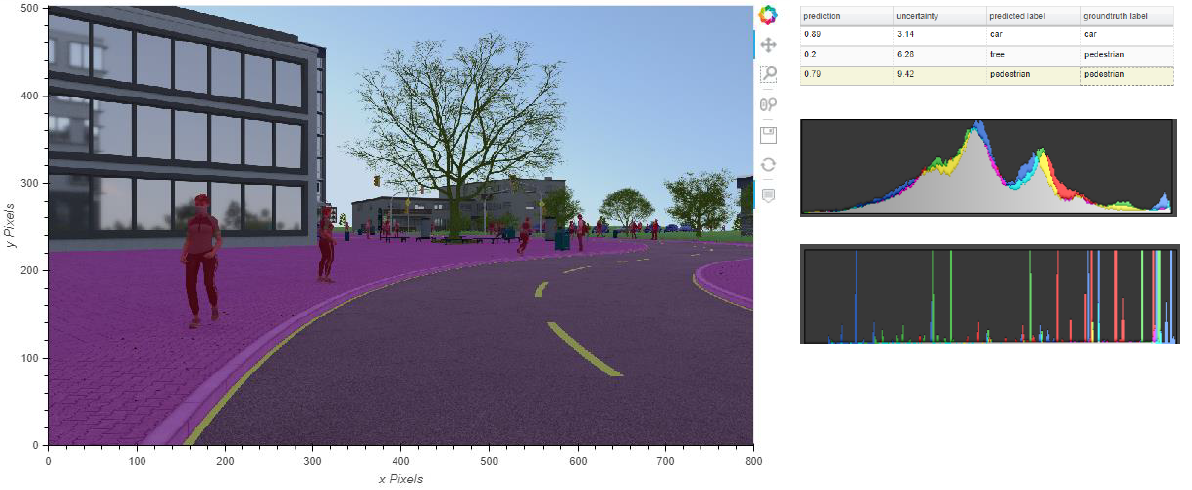

Ein autonomes Fahrzeug verfügt über eine Umfelderkennung, mit der es seine Umwelt wahrnimmt und auf diese reagiert. Diese muss die Bewegungen anderer Verkehrsteilnehmender, etwa von Fußgängern, interpretieren und daraus Intentionen für deren weiteres Verhalten ableiten können. Diese Aufgabe wird in hochautomatisierten Fahrzeugen zunehmend von Künstlicher Intelligenz (KI) in sogenannten KI-Funktionsmodulen übernommen.

KI-Funktionsmodule beobachten, prüfen und zuverlässig absichern

Eine große Herausforderungen bei der Integration der KI-Technologien in hochautomatisiert fahrende Autos ist es, die gewohnte funktionale Sicherheit aller Systeme zu gewährleisten – und diese Sicherheit auch transparent nachweisen zu können.

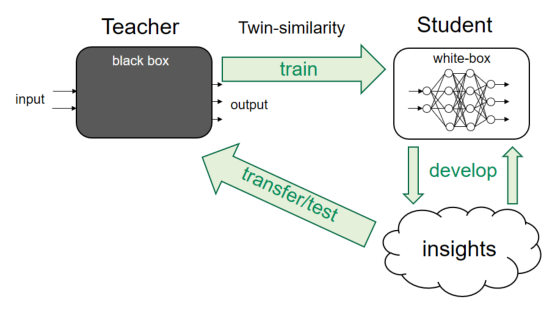

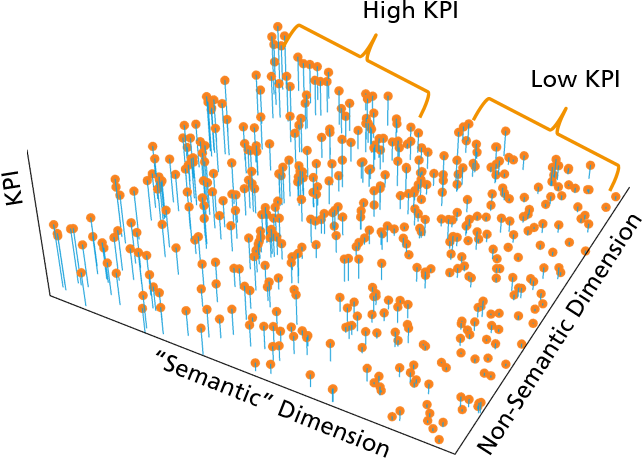

Um diese Herausforderung zu lösen, wurde das vom BMWi geförderte Forschungsprojekt »KI Absicherung« ins Leben gerufen. Unter der Leitung der Volkswagen AG und des Fraunhofer IAIS arbeiteten 25 Partnerunternehmen und -institutionen in dem Projekt daran, einen Industriekonsens zur Absicherung der KI-Funktionsmodule zu schaffen. Dazu gehörten führende Expert*innen aus Industrie und Wissenschaft aus bisher weitgehend unabhängig voneinander agierenden Fachrichtungen der KI-Algorithmen, der 3D-Visualisierung und Animation sowie der funktionalen Sicherheit. Sie erarbeiteten Lösungen, um KI-Funktionsmodule gezielter beobachten, bewerten, prüfen und entsprechend zuverlässig und transparent absichern zu können.

Das Projekt wurde im Rahmen der Leitinitiative »Autonomes und vernetztes Fahren« des Verbandes der Deutschen Automobilindustrie (VDA) durchgeführt und ist Teil der KI-Strategie der Bundesregierung. Neben der Beteiligung im Projekt als stellvertretender Konsortialleiter war das Fraunhofer IAIS der größte Forschungspartner.